Can Sungur ile Stable Diffusion’ı Denedik

Üretken Yapay Zeka GPU’ya ihtiyaç duyuyor

Bu videomuzda Can Sungur ile beraber yapay zeka ile görsel üretme aracı olan Stable Diffusion ile görseller oluşturmayı denedik ve yapay zeka hakkında sohbet ettik.

- Stable Diffusion’ı kurup kendiniz denemek için tıklayın.

Stable Diffusion, girilen resim veya yazıya göre görsel üreten bir derin öğrenme modeli. İş akışınızda size yardımcı olmasının yanı sıra, model bilgisayarınızın kaynaklarını zorlayabiliyor. Sadece işlemci ile 4’lü bir görsel grubu oluşturmak dakikalar sürebiliyor. Bu da geliştiricilerin iş akışını olumsuz şekilde etkileyebilir.

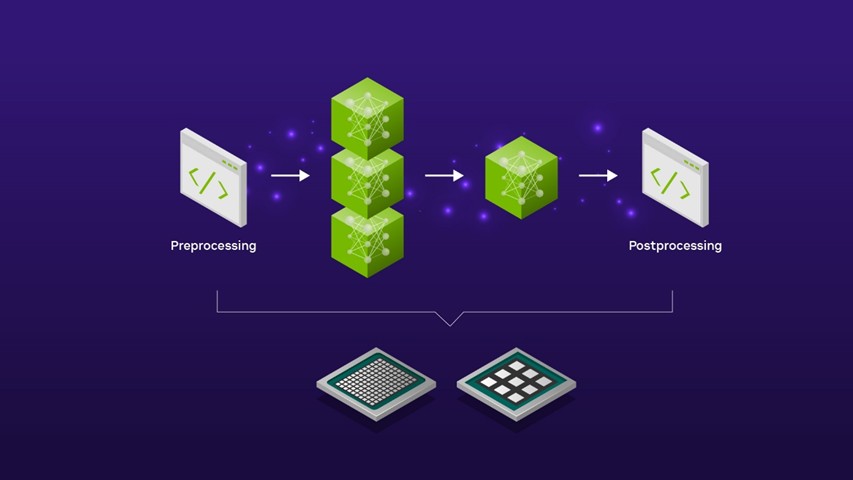

SDXL kullanan pratik kurumsal uygulamalarda model, diğer görüntü işleme modellerini ve işleme öncesi ve sonrası görüntü düzenleme adımlarını içeren daha geniş bir yapay zeka hattının parçasıdır. Örneğin, SDXL kullanarak yeni bir ürün lansmanı kampanyası için bir arka plan sahnesi oluşturmak, ürün görselini sahne oluşturmak üzere SDXL modeline girmeden önce bir ön yakınlaştırma ön işleme adımını gerektirebilir. Ortaya çıkan görüntü çıktısının, bir pazarlama kampanyasında kullanıma uygun hale getirilmeden önce bir görüntü ölçekleyici kullanılarak daha yüksek çözünürlüklere ölçeklendirilmesi gibi ilave işlem sonrası işlemlere de ihtiyacı olabilir.

Kaynak: Nvidia

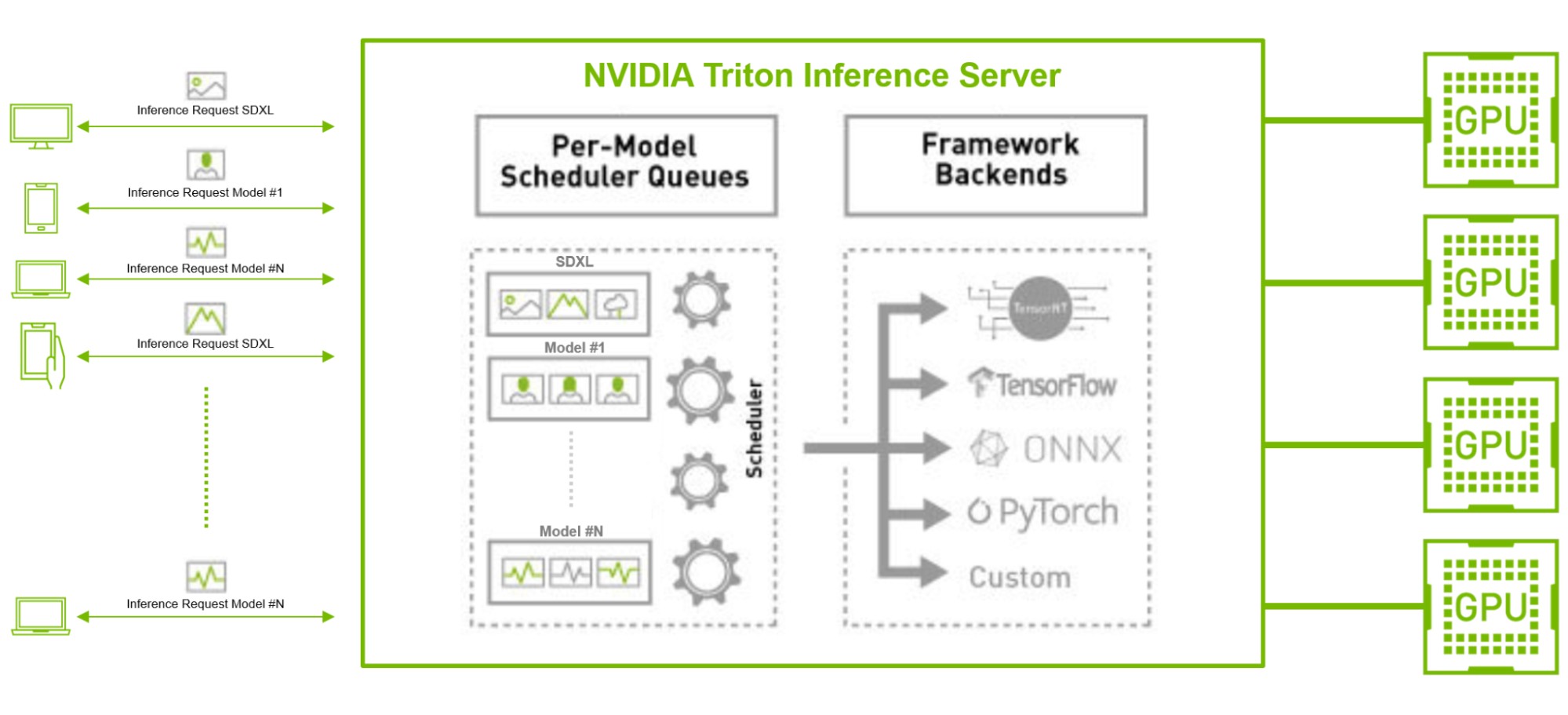

Giderek daha fazla kuruluş Yapay Zekayı kendi iş kollarına dahil etmeyi hedefledikçe, gelen kullanıcı isteklerini verimli bir şekilde gruplama ve GPU kullanımını en üst düzeye çıkarma zorluğu giderek daha karmaşık hale geliyor. Bu karmaşıklık, olumlu bir kullanıcı deneyimi için gecikmeyi en aza indirme ve aynı zamanda operasyonel maliyetleri düşürmek için verimi artırma ihtiyacından kaynaklanmaktadır.

TensorRT gibi açık kaynaklı bir GPU modeli optimize edicinin kullanımı, eş zamanlı model yürütme ve Triton Inference Server gibi dinamik gruplama yeteneklerine sahip bir çıkarım sunucusuyla birleştiğinde bu zorlukları hafifletebilir. Örneğin, özellikle yüksek hacimde gelen müşteri isteklerinin olduğu bir üretim ortamında, bir SDXL modelinin diğer TensorFlow ve PyTorch görüntü sınıflandırma veya özellik çıkarma yapay zeka modelleriyle paralel olarak çalıştırılması senaryosunu düşünün. Burada SDXL modeli, modeli düşük gecikmeli çıkarım için optimize eden TensorRT ile derlenebilir.

Triton Inference Server, dinamik toplu işlem ve eşzamanlı çıkarım yeteneği sayesinde, arka uç çerçevelerinden bağımsız olarak, yüksek hacimli gelen istekleri modeller arasında verimli bir şekilde toplayabilir ve dağıtabilir. Bu yaklaşım, verimi optimize ederek kuruluşların kullanıcı gereksinimlerini daha az kaynakla ve daha düşük toplam sahip olma maliyetiyle karşılamasına olanak tanır.